本地部署大模型方案

本地部署大模型方案

RAG框架:LangChain-Chatchat、AnythingLLM、QAnything、MaxKB、

Agent框架:Dify(对标coze和百度的appbuilder)

Code框架:

UI:Open Web UI(31.6k)、lobe-chat(35.3)、

大模型管理:Ollama(79k)、GPT4All(67.5k 有桌面端)、LLMStudio(1.1k 有UI)、Hugging Face

大模型:llama3、qianwen2、ChatGLM

绘画:Comfy UI、

常见组合:

Ollama+Open Web UI

Ollama+lobe-chat

Ollama+AnythingLLM

大模型 API 平台:Groq、Azure

微信:WeChatMsg、chatgpt-on-wechat

Ollama

安装Ollama

下载Ollama安装包:https://ollama.com/download

安装Ollama,安装成功后可以在任务栏看到Ollama图标,打开命令行,输入以下命令:

Ollama -v可以看到Ollama版本号

安装本地大模型

选择llama3-8B:llama3 (ollama.com)

在命令行运行:

ollama run llama3开始下载模型,下载完即可提问。

llama3经常中英文混答,下载一个qwen2:7b试试

OpenWebUI

【AI】Ollama+OpenWebUI+llama3本地部署保姆级教程,没有连接互联网一样可以使用AI大模型!!!_ollama webui-CSDN博客

open-webui/open-webui: User-friendly WebUI for LLMs (Formerly Ollama WebUI) (github.com)

使用docker安装

如果Ollama在本地,执行命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main打开网站 http://localhost:3000/

注册管理员账号(数据是保存在本地服务的)并登录

停止容器

使用命令停止容器

docker ps

docker stop <容器ID>

AnythingLLM

参考文档:Local Docker Installation ~ AnythingLLM (useanything.com)

使用docker安装

docker pull mintplexlabs/anythingllm将下述多行命令直接复制到 powershell 终端执行

$env:STORAGE_LOCATION="$HOME\Documents\anythingllm"; `

If(!(Test-Path $env:STORAGE_LOCATION)) {New-Item $env:STORAGE_LOCATION -ItemType Directory}; `

If(!(Test-Path "$env:STORAGE_LOCATION\.env")) {New-Item "$env:STORAGE_LOCATION\.env" -ItemType File}; `

docker run -d -p 3001:3001 `

--cap-add SYS_ADMIN `

-v "$env:STORAGE_LOCATION`:/app/server/storage" `

-v "$env:STORAGE_LOCATION\.env:/app/server/.env" `

-e STORAGE_DIR="/app/server/storage" `

mintplexlabs/anythingllm;使用

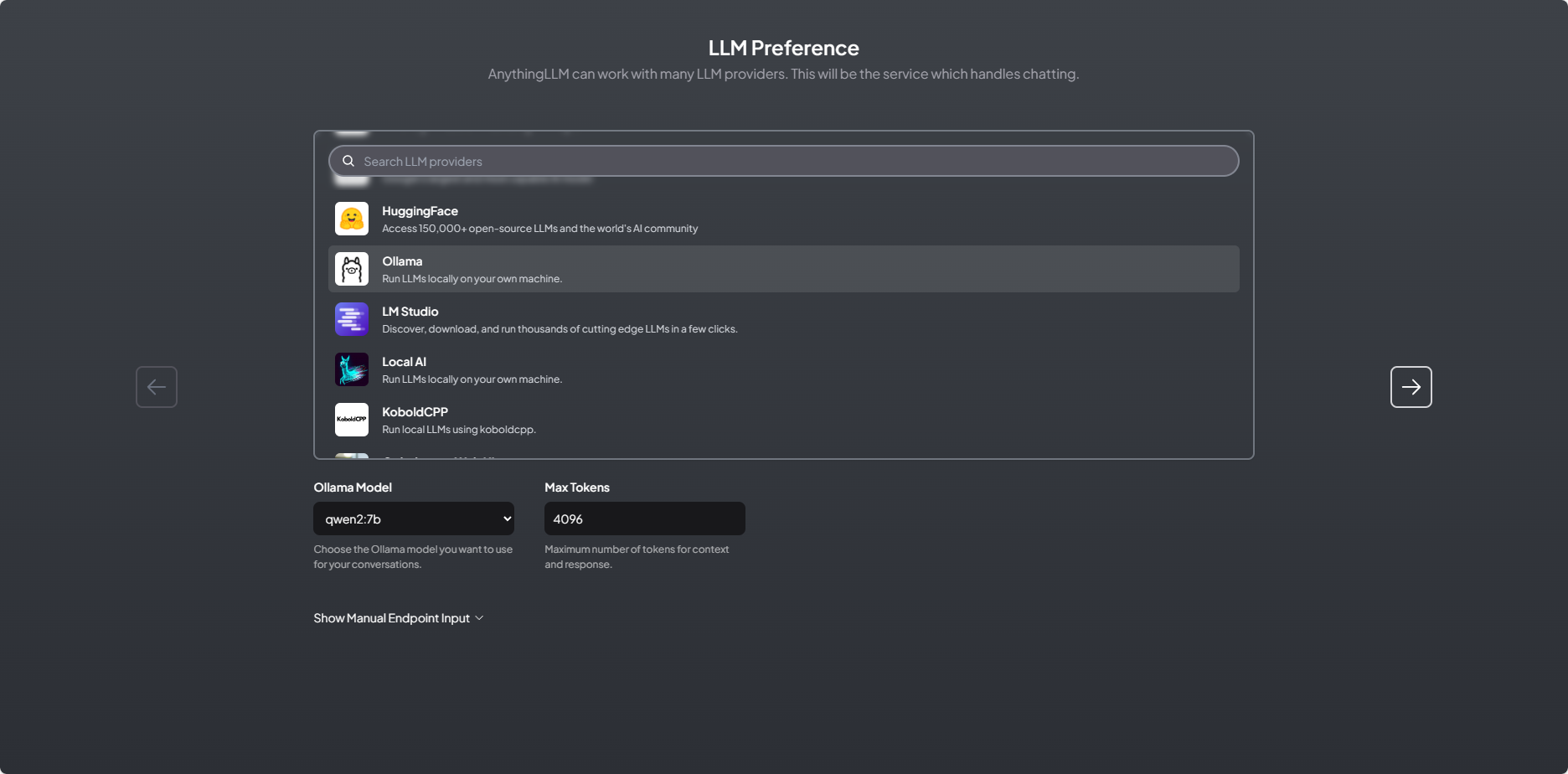

访问 http://localhost:3001/ ,点击 "Get started" 按钮,选择大模型,如 "Ollama",会自动加载出本地模型

点击右侧箭头进入下一步,用户设置,选择"My team"需要设置管理员账号和密码:

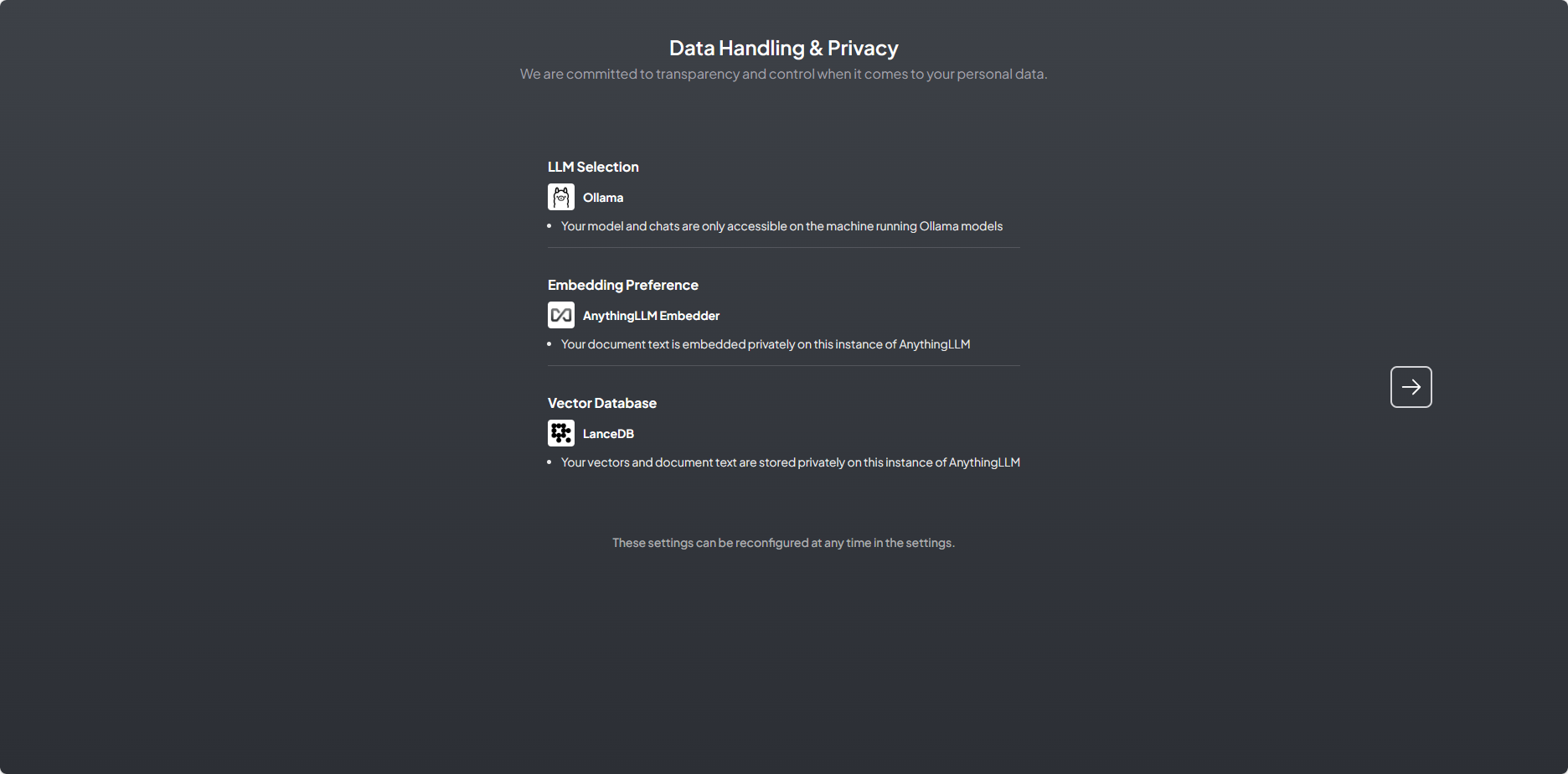

点击右侧箭头进入下一步,会显示出当前选择的大模型、Embedding模型和向量数据库,全部都是本地的

点击右侧箭头进入下一步,点击"Skip Survey"跳过

输入工作空间名称,创建第一个工作空间,然后会以聊天窗口的形式展示一个简单的引导

实际体验,cpu和内存占用都比较高,响应速度慢

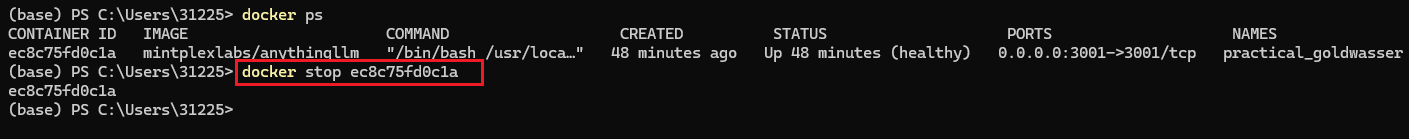

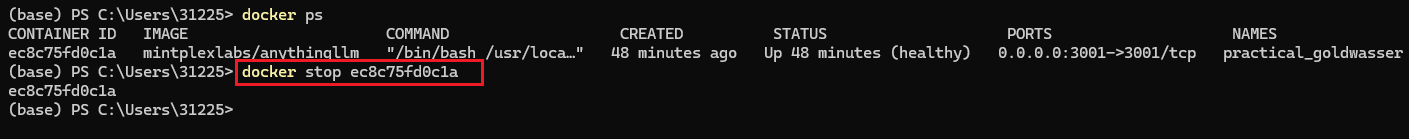

停止容器

使用命令停止容器

docker ps

docker stop <容器ID>